关于那个【第六感运算装置和纸“计算机”】瞎想想……

文章目录

刚刚看了一个TED大会的视频,就是一个印度人的设计。他那个图像扫描一下子让我想到了“东之伊甸”计划。那个需要强大的图像辨识系统和数据库支持,感觉实现起来还是很难的。但是他让我更感兴趣的还是那个随身携带的数字世界——第六感运算装置和纸“计算机”

http://player.youku.com/player.php/sid/XMTQ0MTM5Njg0/v.swf

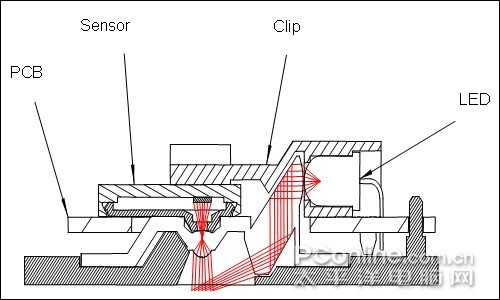

于是我这个对软件啦电子啦基本不通的人YY了一下实现方式。 我觉得做这个东西只需要1只iPhone+4只红外无线的光电鼠标+1个微型投影仪,再加上必要地软件支持就可以了。 (好像有点贵诶……) 那个普拉纳夫的想法是将手指上套上彩色的套子,应该是有个光发射装置和一个蓝牙反馈装置。然后通过摄像机来读取动作并进行操作。但是我想不通的是遇到较远的目标物怎么办?太远难以读取动作,除非用激光,但是激光会不会对人体造成伤害呢?大学物理没学好的我不知道。于是我想换一种方法(也许就是他的方法?不知道,反正我是在YY) 首先,定位采用手指头之间的互相光学定位:由于手指头相距距离不会太远,所以只需要将四个鼠标分别取出发光二极管、微型摄像头、光学引擎和控制芯片集成在一块小套子上,用微型摄像头与另一个套子的相对距离来判定X-Y偏移值,然后通过红外来集合到一个红外模块,用单片机进行解码,模拟iPhone的多点触摸坐标值输入iPhone中。(或者可以直接采用蓝牙,利用iPhone内部的蓝牙模块,不用单片机来解码,而是直接做一个软件来模拟。具体取舍根据蓝牙和红外的价格和可行性来定)。 上一张光学鼠标原理图(随便找找~)

话说为什么要iPhone呢,它那么贵,主要是因为我记忆里好像只有iPhone是多点触摸系统(省的再研究软件了硬件了~

话说为什么要iPhone呢,它那么贵,主要是因为我记忆里好像只有iPhone是多点触摸系统(省的再研究软件了硬件了~我爱iPhone虽然买不起~~)

RT,我只要做一个软件将第一步的数据替换成我的手指得到的数据就可以了。之后的就让iPhone来搞了(我还真是懒啊~~)

当然,iPhone很大的,我可以把壳子啊,屏幕啊,喇叭啊这些没用的模块都去掉,大大节省体积,省下来的空间装个微型投影仪和链接模块。微型投影仪我查了一下,08年就有产品出来了,10年HP也要在本本上装微型投影仪了,所以还是很可行的东西。尤其是早有产品做了一个和ipod相连的装置。要集成的话,可以把iPhone那个接口拆了,排线直接通过那个黑黑的东东里面的必要装置来连到投影仪上(省空间万岁~)

最后呢,iPhone上的摄像头就直接当作摄像头了~再那个盒子统筹一下,随身携带的数字世界就弄好了~~ 需要的软件是:模拟多点触摸的软件(改天想想看具体的数据处理和算法,这是关键),手势记忆识别软件(这个很好做的~),OCR软件(有现成的),条形码识别软件(这个也有现成的~),自动操作软件(就是那个读了文字自己去YouTube上搜视频啊,自己去google上搜天气啦,搜位置啦,搜晚点啦~这个应该也有现成的,没现成的也不要紧。可有可无啦~) 具体使用是这样的:首先手势操作给iPhone处理,同时iPhone上画面通过投影仪实时投影在任何物体上。人就好像对着纸电脑进行操作了~关于什么读报纸的时候看相关视频,这种只要有软件支持,普通手机也能做到。(虽然在天朝不大可行,因为网络太差劲……)条形码的软件,我手机里面就有了~ 就是那个图像扫描识别实在蛮有难度的(至少对于我这个不是软件系也不是电子系的笨蛋来说……当时看东之伊甸的时候有想过怎么去实现,但还是想不到解决方法……)

╮(╯▽╰)╭这个YY就此结束了(如果我有钱我就去试一下可行性……) p.s.又想看小黑书了,又想研究UNIX系统了……不过这个寒假估计是没时间了……下个暑假?恐怕也完成不了的说……我等普通人,还是睡去也…… p.s.2那个印度人名叫pranav,其个人网站是http://www.pranavmistry.com/,智商176,有图片式记忆力(梦寐以求的东东啊~~)。这个是写完日志后没事情干搜到的……

文章作者 ziyunch

上次更新 2010-02-11